当前位置: k8凯发国际官网入口 > 网信动态 > 预警通报 >

相似度可达80%,警惕视频通话“ai换脸”新型诈骗-k8凯发国际官网入口

最近,视频网站上通过人工智能换脸,国产影视剧里的主角用英语说起了台词,通过小程序用户也可以将自己变成电影里的人物,给不少用户带来了欢乐。

类似的视频还有很多外国人“说”地道中文、很多中国艺人“说”起流利的英文……

不少网友感叹,“嘴型、手势都对得上,太自然了,差点儿以为是真的。”“不止嘴形,还有身体动作和语速的配合。”

其实,这些视频有一个共同点:都是由ai(人工智能)生成的。

有网友表示,这种技术看起来很炫酷,应用场景很广泛,未来可能会越来越成熟,比如翻译配音会很自然、传神。

但也有网友表示担忧,“这会不会被用来模仿声音进行诈骗?”“再加上换脸,以后网上啥都不能信了。”“以后视频造假会越来越容易。”

还有网友表示,“希望ai技术发展能被控制在正轨,技术滥用,就是灾难。”

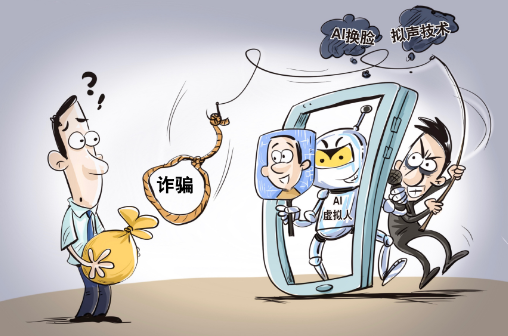

就在前不久,国家金融监督管理总局北京监管局发布谨防“ai换脸”等新型欺诈手段的风险提示。

青岛的一名大学生和他在网上认识的“女朋友”视频聊天,对方称需要资金周转,男孩打钱过去之后,发现竟然被诈骗了。

广东深圳某科技公司产品部经理 梁雅婷:通过取证发现,跟他聊天的并不是他的女朋友,对方是通过虚拟的摄像头,用ai换脸的功能跟他聊天。

ai如何做到在视频通话时换脸呢?记者在一家为公安机关提供k8凯发国际官网入口的技术支持的科技公司看到的演示,相似度可以达到80%。

记者在现场看到,一个高配置的电脑,合成一段10秒的换脸视频只需要一两分钟。而技术的发展,上述案件中视频聊天的实时变脸也不是难事了。

广东深圳某科技公司产品部经理 刘远洋:照片上传后,大概有30秒的时间对照片进行特征识别,然后建模,建模后就可以进行实时转换。不管是你的头像,还是你在朋友圈的一张小照片,都可以直接上传。

ai生成的技术还在不断更新迭代,比如性别的互换、声音的变换,都可以同步进行。由于算法是开源的,也就是说一个普通的工程师就可以制作出一个变脸软件,这就在控制源头上带来了极大的困难。

不断迭代的ai技术,已经把换脸视频做到“真假难辨”,我们应该如何防范此类新型诈骗呢?戳视频了解↓↓↓

(来源:央视财经、中央广电总台中国之声)

- 【上一篇】凡是让你扫码的不明卡片,都直接扔掉!

- 【下一篇】这些都是假的!市场监管总局发声